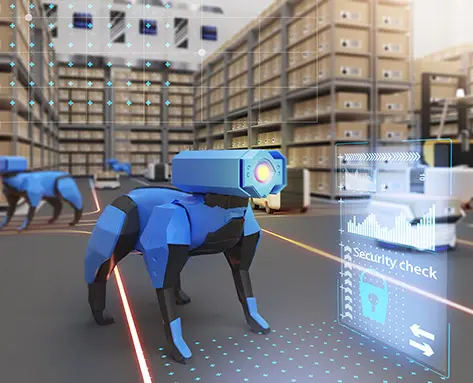

Wir freuen uns, ankündigen zu können, dass eInfochips auf der kommenden NVIDIA GTC Veranstaltung zwei innovative Demos präsentieren wird! Die erste Demo ist JetCarrier96, ein Referenzdesign für OEM-Kunden, die eine kundenspezifische Trägerplatine für die NVIDIA Jetson Edge AI- und Robotik-Plattform erstellen möchten. Dieses Board verfügt über die neuesten Technologien, die üblicherweise in fortgeschrittenen und vereinfachten Carrier-Board-Designs zu finden sind, und ermöglicht es den Kunden, die Subsysteme auszuwählen, die ihren Anforderungen am besten entsprechen. Wir werden auf der Veranstaltung auch das Referenzdesign des Arrow SmartRover AMR vorstellen. Diese Plattform vereinfacht die Entwicklung autonomer mobiler Roboter, indem sie eine sofort einsatzbereite Lösung für das Testen von Roboternavigation, Objekterkennung, Kollisionsvermeidung und Indoor Scene Mapping bietet.

Und das ist noch nicht alles - wir werden auf der Veranstaltung auch zwei Webcasts veranstalten, in denen wir die neuesten Trends und Erkenntnisse zu autonomen mobilen Robotern vertiefen werden.

Wichtige Kundenengagements

Autonome mobile Roboter: Trends und Technologien

14. März 2024

Präsentiert von:

Amit Gupta und Harsh Vardhan Singh

Überblick - Unternehmen setzen auf autonome mobile Roboter (AMR), um sich wiederholende und körperlich anspruchsvolle Aufgaben zu rationalisieren. Durch die Integration von künstlicher Intelligenz und maschinellem Lernen werden AMRs noch intelligenter und anpassungsfähiger. Bei eInfochips verfügen wir über ein Robotics Center of Excellence (CoE) mit einem qualifizierten Team von Experten für die entsprechenden Plattformen und Technologien. Unser Team hat erfolgreich mehrere AMR-Proof-of-Concepts und Komplettlösungen für unsere Kunden entwickelt.

Wichtigste Highlights

- Trends und Überlegungen zur Robotik

- Schlüsseltechnologien und Komponenten

- Anwendungsfall und Lösungen

Nutzung von KI-Techniken für ein fortgeschrittenes, auf Computervisionen basierendes Szenenverständnis in 2D- und 3D-Bereichen

04. April 2024

Präsentiert von:

Man Mohan Tripathi und Pallavi Pansare

Überblick - Computer Vision ist ein Bereich der künstlichen Intelligenz (AI), der es Computern ermöglicht, Bilder und Videos zu verstehen und daraus sinnvolle Informationen abzuleiten, um sinnvolle Aktionen durchzuführen. Mit Computer Vision werden Maschinen trainiert, diese Funktionen auszuführen, aber sie müssen dies in viel kürzerer Zeit mit Kameras, Daten und Algorithmen tun. In der Vergangenheit war die Computer Vision auf 2D-Bilder beschränkt, aber dank des technischen Fortschritts ist sie nun auch auf 3D-Bilder anwendbar! Das bedeutet, dass Maschinen jetzt Tiefe und Dimensionen wahrnehmen können, was eine noch genauere und ausgefeiltere Analyse ermöglicht.

Wichtigste Highlights

- Trends und Überlegungen zur Computer Vision

- 2D vs. 3D Computer Vision

- Anwendungsfall und Lösungen

NVIDIA GTC-Veranstaltung 2023

WEBCAST 1

WEBCAST 2

Vortragende

Amit Gupta

Amit leitet derzeit das Kompetenzzentrum für Robotik und ist Teil eines Lösungsteams am eInfochips-Standort in Noida, Indien. Amit verfügt über mehr als 23 Jahre Erfahrung in der Halbleiter-/Elektronikindustrie, wobei er alle Phasen von der Innovation bis zur Monetarisierung durchlaufen hat. Er hat komplette Produkte und Lösungen mit funktionsübergreifenden Teams (Hardware, Firmware, Mechanik, Cloud, App und Zertifizierungen) konzipiert, um für Kunden in den Bereichen KI, Robotik, Industrie 4.0, Internet der Dinge, Smart Utility, Telemedizin und Asset Tracking einen ROI zu erzielen.

Harsh Vardhan Singh

Harsh Vardhan Singh hat einen Master-Abschluss in Informatik vom Georgia Institute of Technology mit Spezialisierung auf maschinelles Lernen (OMSCS). Er ist Ingenieur in der Lösungsforschung und arbeitet derzeit an der Sensorfusion und dem Navigations-Stack innerhalb der ROS 2-Umgebung für ein Proof-of-Concept eines autonomen mobilen Roboters. Harsh verfügt über rund sieben Jahre Industrieerfahrung, von denen er zunächst sechs Jahre in den Forschungs- und Innovationslabors verbrachte. Er hat an mehreren Projekten gearbeitet, die Anwendungen von Computer Vision, KI, Deep Learning, maschinellem Lernen, Reinforcement Learning und Robotik beinhalten.

Man Mohan Tripathi

Starker Ingenieur mit einem Master of Technology (MTech.) mit Schwerpunkt Künstliche Intelligenz von der University of Hyderabad. ManMohan hat mehr als 8 Jahre Erfahrung in Deep Learning, Computer Vision und Internet of Things (IoT). Seine aktuellen Interessengebiete sind 3D Computer Vision, Tiefenbildgebung und Deep Neural Network. Er arbeitet bei eInfochips Inc. als Solution Engineer.

Pallavi Pansare

Pallavi Pansare arbeitet derzeit als Solution Engineer bei eInfochips und verfügt über mehr als 4 Jahre Erfahrung in Bereichen wie Signalverarbeitung, Bildverarbeitung, Computer Vision, Deep Learning und maschinelles Lernen. Sie hat einen Master-Abschluss in Signalverarbeitung und promoviert derzeit in künstlicher Intelligenz. Sie hat an KI/ML-Projekten im Zusammenhang mit Bildsuperauflösung und Bildsegmentierung gearbeitet und beschäftigt sich derzeit mit 3D-Objekterkennung.

Verwandte Blogs

Sensor-Fusion - Teil 1

Dieser Blog ist der erste Teil einer zweiteiligen Serie, in der wir die Verwendung von Sensorfusion in autonomen mobilen Robotern (AMRs) vorstellen, die mit ROS 2 (Robot Operating System 2) arbeiten können. In diesem Teil werden wir eine Einführung in die Sensorfusion geben, einen kurzen Überblick über einen Sensorfusionsalgorithmus namens EKF (Extended Kalman Filters) geben und dann einige der Experimente durchführen, die wir in der Simulation und auf unserem AMR durchgeführt haben.

Sensor-Fusion - Teil 2

Dieser Blog ist der zweite Teil einer zweiteiligen Serie, in der wir die Verwendung von Sensorfusion in autonomen mobilen Robotern (AMRs) vorstellen, die mit ROS (Robot Operating System) 2 arbeiten können. Im ersten Teil haben wir die Sensorfusion vorgestellt, kurz einen Sensorfusionsalgorithmus namens EKF (Extended Kalman Filters) behandelt und dann einige der Experimente durchgespielt, die wir in der Simulation und an unserem AMR durchgeführt haben.

Vom Konzept zur Fertigstellung: Rationalisierung der 3D-Szenenerstellung für die Robotik mit Nvidia Isaac Sim und Blender

In diesem Artikel werden die Vorteile und Herausforderungen der Kombination von Blender und Nvidia Isaac Sim zur Erstellung realistischer Simulationen für Robotikanwendungen erörtert. Durch die Integration der 3D-Modellierungs- und Animationsfunktionen von Blender mit der Simulationssoftware von Nvidia Isaac Sim können detailliertere und genauere Modelle zum Testen und Verfeinern von Algorithmen entwickelt werden. Darüber hinaus können mit Nvidia Isaac Sim generierte synthetische Daten zum Trainieren von Deep-Perception-Modellen verwendet werden, was den Zeit- und Arbeitsaufwand für das Sammeln und Beschriften von Datensätzen reduziert.

Steuern Sie Ihren Roboter mit micro-ROS und NVIDIA Jetson Kit

ROS ist ein Open-Source-Framework, das die Entwicklung komplexer Roboteranwendungen vereinfacht. Es nutzt eine verteilte Architektur, die die Kommunikation zwischen verschiedenen Softwarekomponenten innerhalb eines Robotersystems erleichtert.

AMR-Navigation mit Isaac ROS VSLAM und Nvblox mit Intel Realsense Kamera

Die Navigation von autonomen mobilen Robotern (AMR) stützt sich in hohem Maße auf visuelles SLAM, was für visuelle simultane Lokalisierung und Kartierung steht. Bei dieser Technik wird eine Kamera verwendet, um die Position des Roboters zu bestimmen und gleichzeitig eine Karte der Umgebung zu erstellen. Visuelles SLAM ist entscheidend für Marserkundungsgeräte, unbemannte Roboter, Endoskopie und Staubsauger.

Training und Einsatz des DL-Modells mit simulierten Daten

Simulierte Daten werden für das Training und den Einsatz von Deep-Learning-Modellen immer beliebter. Fortschritte in der Simulationstechnologie ermöglichen die Erzeugung realistischer synthetischer Daten für Anwendungen wie Robotik, autonome Fahrzeuge und Computer Vision. Obwohl simulierte Daten kosteneffektiv und effizient sind, muss beim Einsatz von Modellen in der realen Welt sorgfältig auf Übertragbarkeit und Verallgemeinerung geachtet werden.

Autonome Navigation von AMR mit RTAB-Map und ToF-Kamera

Die Erkundung ist ein wichtiger Aspekt der autonomen Navigation in der Robotik. Simultane Lokalisierung und Kartierung (SLAM) ist eine grundlegende Technik, die es Robotern ermöglicht, unbekannte Umgebungen zu navigieren und zu kartieren. Visuelle simultane Lokalisierung und Kartierung oder visuelles SLAM (VSLAM) ist eine spezielle Art von SLAM, die es Robotern ermöglicht, ihre Umgebung zu kartieren und ihre eigene Position, d. h. die Odometrie, in Echtzeit mithilfe visueller Eingaben von Kameras zu schätzen.