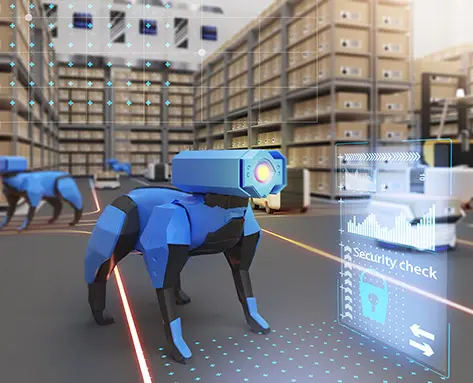

Nous sommes ravis d'annoncer qu'eInfochips présentera deux démos à la pointe de la technologie lors du prochain événement NVIDIA GTC ! La première démo est JetCarrier96, un design de référence pour les clients OEM qui cherchent à créer une carte porteuse personnalisée pour la plate-forme NVIDIA Jetson Edge AI et Robotics. Cette carte présente les dernières technologies que l'on trouve couramment dans les conceptions de cartes porteuses avancées et simplifiées, ce qui permet aux clients de choisir les sous-systèmes qui répondent le mieux à leurs besoins. Nous présenterons également la conception de référence Arrow SmartRover AMR lors de l'événement. Cette plateforme simplifie le développement de robots mobiles autonomes en fournissant une solution prête à l'emploi pour tester les capacités de navigation, de détection d'objets, d'évitement des collisions et de cartographie de scènes intérieures des robots.

Et ce n'est pas tout - nous organiserons également deux webcasts lors de l'événement pour approfondir les dernières tendances et connaissances en matière de robots mobiles autonomes.

Engagements auprès des clients clés

Robots mobiles autonomes : Tendances et technologies

14 mars 2024

Présenté par :

Amit Gupta et Harsh Vardhan Singh

Présentation - Les entreprises se tournent vers les robots mobiles autonomes (AMR) pour rationaliser les tâches répétitives et physiquement exigeantes. Avec l'intégration de l'intelligence artificielle et de l'apprentissage automatique, les AMR deviennent encore plus intelligents et adaptatifs. Chez eInfochips, nous avons un Centre d'Excellence en Robotique (CoE) avec une équipe d'experts compétents dans les plateformes et technologies concernées. Notre équipe a développé avec succès plusieurs AMR proof-of-concepts et des solutions complètes pour nos clients.

Faits marquants

- Tendances et considérations pour la robotique

- Technologies et composants clés

- Cas d'utilisation et solutions

Exploitation des techniques d'IA pour une compréhension avancée des scènes en 2D et 3D basée sur la vision par ordinateur

04 avril 2024

Présenté par :

Man Mohan Tripathi et Pallavi Pansare

Vue d'ensemble - La vision par ordinateur est un domaine de l'intelligence artificielle (IA) qui permet aux ordinateurs de comprendre les images et les vidéos et d'en tirer des informations utiles pour effectuer des actions significatives. La vision par ordinateur entraîne les machines à exécuter ces fonctions, mais elle doit le faire en beaucoup moins de temps avec des caméras, des données et des algorithmes. Dans le passé, la vision par ordinateur se limitait aux images en 2D, mais grâce aux progrès technologiques, elle s'étend désormais à la 3D ! Cela signifie que les machines peuvent désormais percevoir la profondeur et les dimensions, ce qui permet des analyses encore plus précises et sophistiquées.

Faits marquants

- Tendances et considérations pour la vision par ordinateur

- Vision par ordinateur 2D et 3D

- Cas d'utilisation et solutions

Événement NVIDIA GTC 2023

ÉMISSION 1

ÉMISSION 2

Présentateurs

Amit Gupta

Amit dirige actuellement le centre d'excellence en robotique et fait partie d'une équipe de solutions basée à Noida, en Inde. Amit a plus de 23 ans d'expérience dans l'industrie des semi-conducteurs et de l'électronique, de l'innovation à la monétisation. Il a conçu des produits et des solutions complètes impliquant des équipes interfonctionnelles (matériel, firmware, mécanique, cloud, applications et certifications) afin d'obtenir un retour sur investissement pour les clients dans les domaines de l'intelligence artificielle, de la robotique, de l'industrie 4.0, de l'internet des objets, des services publics intelligents, de la télésanté et du suivi des actifs.

Harsh Vardhan Singh

Harsh Vardhan Singh est titulaire d'une maîtrise en informatique de l'Institut de technologie de Géorgie, avec une spécialisation en apprentissage automatique (OMSCS). Il est ingénieur en recherche de solutions et travaille actuellement sur la fusion de capteurs et la pile de navigation dans l'environnement ROS 2 pour un prototype de robot mobile autonome. Harsh a environ sept ans d'expérience industrielle, dont six ans passés dans les laboratoires de recherche et d'innovation. Il a travaillé sur de nombreux projets impliquant des applications de vision par ordinateur, d'IA, d'apprentissage profond, d'apprentissage automatique, d'apprentissage par renforcement et de robotique.

Man Mohan Tripathi

Professionnel de l'ingénierie, ManMohan est titulaire d'un Master of Technology (MTech.) en Intelligence Artificielle de l'Université d'Hyderabad. ManMohan a plus de 8 ans d'expérience dans l'apprentissage profond, la vision par ordinateur et l'Internet des objets (IoT). Ses domaines d'intérêt actuels sont la vision informatique 3D, l'imagerie de profondeur et les réseaux neuronaux profonds. Il travaille avec eInfochips Inc en tant qu'ingénieur de solution.

Pallavi Pansare

Pallavi Pansare travaille actuellement en tant qu'ingénieur solution chez eInfochips avec plus de 4 ans d'expertise dans des domaines tels que le traitement du signal, le traitement de l'image, la vision par ordinateur, l'apprentissage profond et l'apprentissage automatique. Elle est titulaire d'une maîtrise en traitement du signal et poursuit actuellement son doctorat en intelligence artificielle. Elle a travaillé sur des projets d'IA/ML liés à la super résolution d'images, à la segmentation d'images, et travaille actuellement sur la détection d'objets en 3D.

Blogs associés

Fusion de capteurs - Partie 1

Ce blog est la première partie d'une série en deux parties dans laquelle nous introduirons l'utilisation de la fusion de capteurs dans les Robots Mobiles Autonomes (AMR) qui sont capables de travailler avec ROS 2 (Robot Operating System 2). Dans cette partie, nous allons introduire la fusion de capteurs, couvrir brièvement un algorithme de fusion de capteurs appelé EKF (Extended Kalman Filters), et ensuite passer en revue certaines des expériences que nous avons faites en simulation et sur notre AMR.

Fusion de capteurs - Partie 2

Ce blog est la deuxième partie d'une série en deux parties où nous présenterons l'utilisation de la fusion de capteurs dans les Robots Mobiles Autonomes (AMR) qui sont capables de travailler avec ROS (Robot Operating System) 2. Dans la première partie, nous avons présenté la fusion de capteurs, brièvement couvert un algorithme de fusion de capteurs appelé EKF (Extended Kalman Filters), puis nous avons passé en revue certaines des expériences que nous avons faites en simulation et sur notre AMR.

Du concept à la réalisation : Rationaliser la création de scènes 3D pour la robotique avec Nvidia Isaac Sim et Blender

L'article traite des avantages et des défis liés à la combinaison de Blender et de Nvidia Isaac Sim pour créer des simulations réalistes pour les applications robotiques. En intégrant les capacités de modélisation et d'animation 3D de Blender au logiciel de simulation Nvidia Isaac Sim, il est possible de développer des modèles plus détaillés et plus précis pour tester et affiner les algorithmes. En outre, les données synthétiques générées par Nvidia Isaac Sim peuvent être utilisées pour entraîner des modèles de perception profonde, ce qui réduit le temps et les efforts nécessaires à la collecte et à l'annotation des ensembles de données.

Contrôlez votre robot à l'aide de micro-ROS et du kit NVIDIA Jetson

ROS est un logiciel libre qui simplifie le développement d'applications robotiques complexes. Il utilise une architecture distribuée qui facilite la communication entre les différents composants logiciels au sein du système d'un robot.

Navigation AMR utilisant Isaac ROS VSLAM et Nvblox avec la caméra Intel Realsense

La navigation des robots mobiles autonomes (AMR) repose en grande partie sur le SLAM visuel, c'est-à-dire la localisation et la cartographie visuelles simultanées. Cette technique utilise une caméra pour estimer la position du robot tout en créant simultanément une carte de l'environnement. Le SLAM visuel est essentiel pour les dispositifs d'exploration de Mars, les robots sans pilote, l'endoscopie et le nettoyage par le vide.

Formation et déploiement du modèle DL à l'aide de données simulées

Les données simulées sont de plus en plus populaires pour l'entraînement et le déploiement de modèles d'apprentissage profond. Les progrès de la technologie de simulation permettent de générer des données synthétiques réalistes pour des applications telles que la robotique, les véhicules autonomes et la vision par ordinateur. Bien que les données simulées soient rentables et efficaces, le déploiement de modèles dans le monde réel nécessite un examen attentif de la transférabilité et de la généralisation.

Navigation autonome de l'AMR à l'aide de la carte RTAB et de la caméra ToF

L'exploration est un aspect crucial de la navigation autonome en robotique. La localisation et la cartographie simultanées (SLAM) est une technique fondamentale qui permet aux robots de naviguer et de cartographier des environnements inconnus. La localisation et la cartographie simultanées visuelles, ou SLAM visuel (VSLAM), est un type spécifique de SLAM qui permet aux robots de cartographier leur environnement et d'estimer leur propre position, c'est-à-dire l'odométrie, en temps réel à l'aide de données visuelles provenant de caméras.