Navigation autonome de l'AMR à l'aide de la carte RTAB et de la caméra ToF

Auteurs : Sagar Dhatrak, Vishal Raval | Date : 21 March 2023 | Catégorie : Automobile

Introduction

L'exploration est un aspect crucial de la navigation autonome en robotique. La localisation et la cartographie simultanées (SLAM) est une technique fondamentale qui permet aux robots de naviguer et de cartographier des environnements inconnus. La localisation et la cartographie simultanées visuelles, ou SLAM visuel (VSLAM), est un type spécifique de SLAM qui permet aux robots de cartographier leur environnement et d'estimer leur propre position, c'est-à-dire l'odométrie, en temps réel à l'aide de données visuelles provenant de caméras. Cette technique a été largement utilisée dans diverses applications, notamment les rovers martiens, les hélicoptères martiens, les robots terrestres, les robots sous-marins et les robots aspirateurs. Des études ont été menées pour déterminer dans quelle mesure la caméra à temps de vol (ToF) fonctionne avec RTAB-Map pour la navigation autonome des robots mobiles autonomes (AMR) en utilisant uniquement des images de profondeur. La caméra ToF capture à la fois des images infrarouges (IR) et des images de profondeur. L'image de profondeur est utilisée pour créer un nuage de points 3D ( ). Le nuage de points 3D et l'odométrie des roues sont utilisés par RTAB-Map pour produire une odométrie corrigée et une carte de grille d'occupation 2D pour la navigation autonome des AMR.

Qu'est-ce que la caméra à temps de vol (ToF) ?

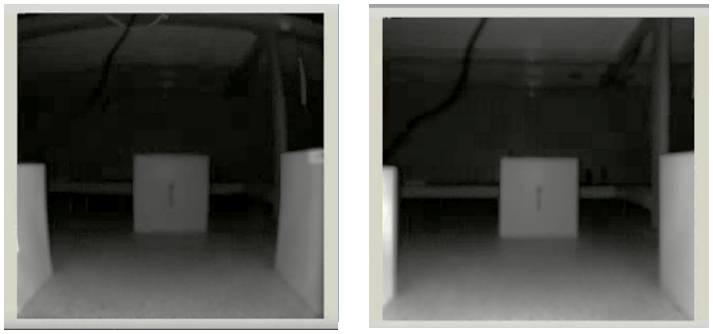

La caméra ToF est une caméra de profondeur Analog Devices basée sur le processeur de signal TOF ADSD3100. Elle prend en charge le traitement des données sur la plate-forme du processeur intégré, en plus de la connexion USB, Ethernet ou Wi-Fi à un ordinateur hôte. La caméra ToF est conçue pour être utilisée dans des applications industrielles, automobiles et grand public. Elle utilise une méthode de temps de vol pour calculer la distance des objets dans la scène, ce qui lui permet de créer des cartes de profondeur précises. La caméra ToF fournit des images infrarouges (IR) et des images de profondeur, comme le montre la figure 1.

Architecture de RTAB-Map

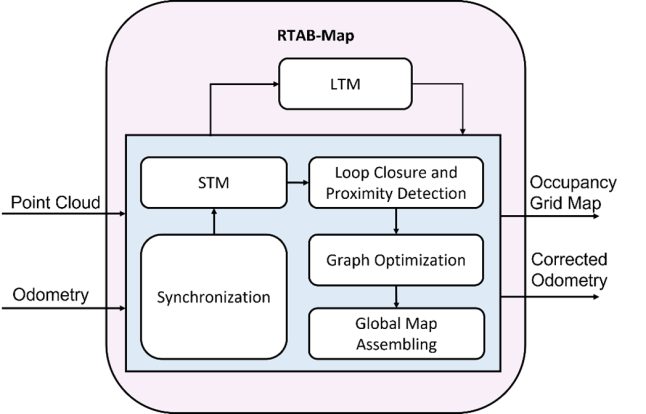

La cartographie en temps réel basée sur l'apparence (RTAB-Map) est une technique SLAM basée sur les graphes. RTAB-Map intègre une approche de détection de fermeture de boucle basée sur l'apparence et une approche de gestion de la mémoire pour traiter la cartographie en ligne à grande échelle et à long terme. L'odométrie, c'est-à-dire la pose de l'AMR, est une entrée externe de RTAB-Map. Par conséquent, tout type d'odométrie approprié à une application donnée peut être utilisé, y compris l'odométrie de la roue, l'odométrie visuelle et l'odométrie ICP. Quatre configurations d'entrée différentes peuvent être utilisées avec RTAB-Map :

- Image RVB, image de profondeur et odométrie

- Images stéréoscopiques et odométrie

- Nuage de points 3D et odométrie

- Numérisation laser 2D et odométrie

La figure 2 illustre les différents blocs de RTAB-Map. Un nuage de points 3D et l'odométrie sont les entrées que RTAB-Map utilise pour notre cas d'utilisation. En outre, il a besoin de deux transformées d'entrée : la transformée odom vers base_link et la transformée base_link vers camera_link. RTAB-Map produit en sortie la transformation de la carte en odom, la carte de la grille d'occupation 2D et l'odométrie corrigée. Le nœud RTAB-Map se compose des blocs suivants : Synchronisation, mémoire à court terme (STM), mémoire à long terme (LTM), fermeture de boucle et détection de proximité, optimisation du graphique et assemblage de la carte globale.

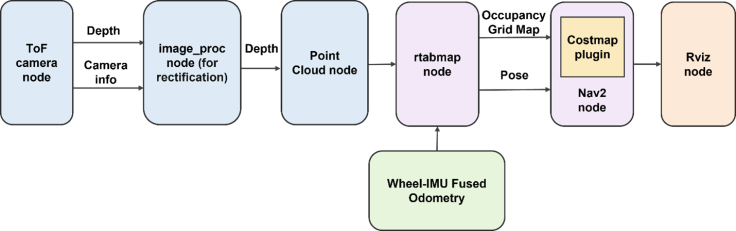

Flux de travail de la RTAB-Map et de la pile Nav2 avec une caméra ToF

La figure 3 présente l'ensemble du processus de navigation autonome d'AMR à l'aide de rtabmap, d'une caméra ToF et d'une odométrie fusionnée roue-IMU. L'odométrie fusionnée roue-IMU est obtenue en fusionnant les données de l'encodeur de la roue et les données IMU à l'aide d'un filtre de Kalman étendu pour obtenir une odométrie robuste. Comme nous pouvons le voir, il y a sept nœuds : nœud caméra ToF, nœud image_proc, nœud nuage de points, nœud rtabmap, nœud odométrie fusionnée roue-IMU, nœud Nav2 et nœud Rviz. Le paragraphe suivant explique la fonctionnalité de ces nœuds.

Le premier nœud du pipeline est celui de la caméra ToF, qui capture les images IR et de profondeur. Les images capturées sont ensuite rectifiées par le nœud image_proc afin d'éliminer les distorsions tangentielles et radiales. Les images IR rectifiées sont utilisées pour la visualisation dans Rviz. Le nœud de nuage de points génère des nuages de points 3D à partir des images de profondeur rectifiées. Le nœud d'odométrie fusionnée roue-IMU estime l'odométrie de l'AMR à l'aide des codeurs de roue et des données IMU. Le nœud rtabmap utilise l'odométrie fusionnée roue-IMU et le nuage de points généré pour produire la carte de la grille d'occupation en 2D et l'odométrie corrigée (c.-à-d. la pose). Un nœud Nav2 utilise la carte de la grille d'occupation générée et l'odométrie pour générer une carte des coûts qui est utilisée pour la planification de la trajectoire et la navigation autonome de l'AMR. Enfin, le nœud Rviz est utilisé comme outil de visualisation pour afficher l'image IR, l'odométrie et la carte de la grille d'occupation. Il permet également de définir la pose de l'objectif de l'AMR. Dans l'ensemble, le pipeline combine divers capteurs et nœuds pour permettre la navigation autonome de l'AMR.

Discussion des résultats de l'expérience

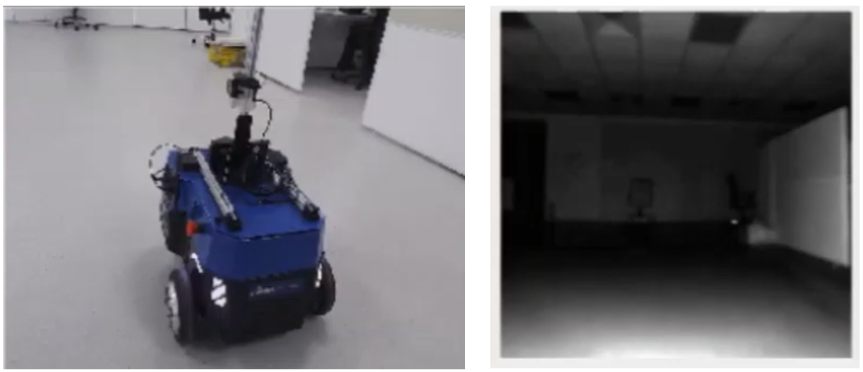

La figure 3 montre l'AMR, ce qu'il voit à travers la caméra realsense dont il est équipé et la carte du nuage de points 3D qui en résulte sous la forme d'un maillage. La figure 4 montre la carte créée avec l'état d'objectif donné, la trajectoire planifiée et l'AMR arrivant en toute sécurité à l'état d'objectif en suivant la trajectoire planifiée.

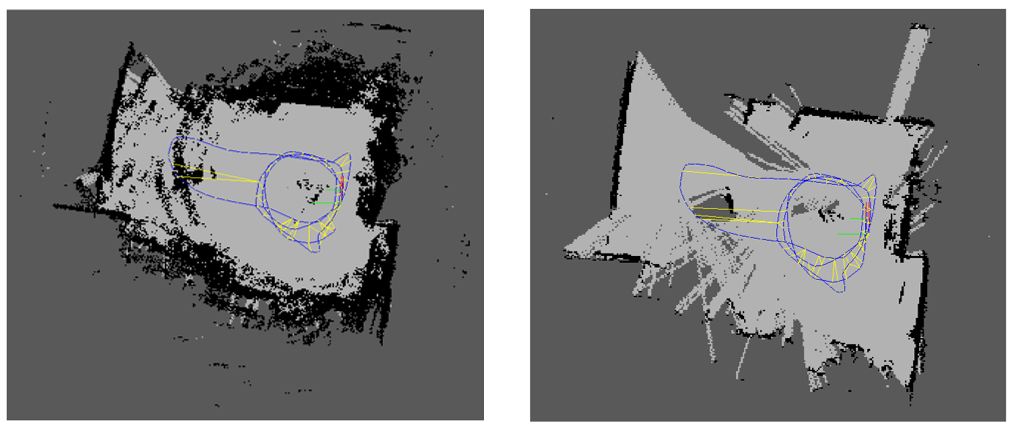

En outre, le nuage de points généré à l'aide de l'image de profondeur rectifiée de la caméra ToF fait apparaître les surfaces planes du monde réel comme des surfaces courbes dans le nuage de points. Un post-traitement est donc nécessaire pour résoudre ce problème. La figure 6 montre la carte de la grille d'occupation avant le filtrage du nuage de points et après le filtrage du nuage de points. Les lignes bleues dans cette fenêtre indiquent l'odométrie estimée de l'AMR.

Figure 6 La fenêtre de gauche montre la carte de la grille d'occupation avant le filtrage des nuages de points, tandis que la fenêtre de droite montre la carte de la grille d'occupation après le filtrage des nuages de points. Les lignes bleues dans les deux fenêtres indiquent l'odométrie estimée de l'AMR.

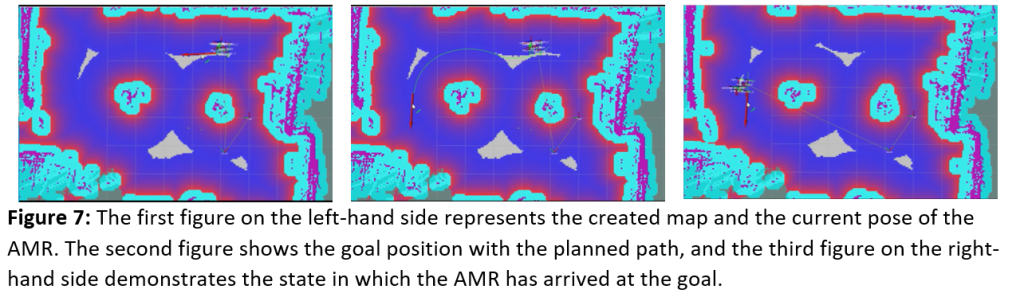

La figure 7 illustre les différentes étapes du processus de navigation autonome. La première figure de gauche montre la carte générée avec la position actuelle de l'AMR. La carte est générée par le nœud rtabmap à l'aide de l'odométrie fusionnée roue-IMU et du nuage de points. La deuxième figure au centre représente la position de l'objectif avec la trajectoire planifiée. Une fois la position du but définie dans Rviz, le nœud Nav2 planifie une trajectoire à l'aide de la carte des coûts générée à partir de la carte de la grille d'occupation et de la pose de l'odométrie. La trajectoire planifiée est affichée dans Rviz à des fins de visualisation. Enfin, la troisième figure de droite montre que l'AMR a atteint son objectif. Une fois la trajectoire planifiée, l'AMR utilise la position corrigée de l'odométrie et la carte des coûts pour naviguer vers la position cible. L'AMR met continuellement à jour sa position à l'aide de l'odométrie fusionnée roue-IMU et de la carte de la grille d'occupation, et ajuste sa trajectoire pour suivre le chemin prévu. Lorsque l'AMR atteint la position cible, il s'arrête et le processus de navigation est terminé.

Conclusion

Une caméra ToF a été intégrée à RTAB-Map et à la pile Nav2 pour naviguer de manière autonome dans l'AMR dans un environnement de laboratoire. Plusieurs défis ont été relevés lors de l'utilisation de la ToF avec RTAB-Map pour la navigation autonome de l'AMR. Les images IR et de profondeur fournies par la ToF doivent être rectifiées, car une image de profondeur non rectifiée peut conduire à une carte inexacte. Nous avons observé que les objets plats semblaient courbés dans le nuage de points, ce qui a été résolu grâce au post-traitement du nuage de points. Il est nécessaire de filtrer le nuage de points avant de le transmettre à RTAB-Map. Parallèlement, l'AMR construit la carte et localise sa position dans la carte pour une navigation sûre en utilisant l'image de profondeur de ToF et l'algorithme RTAB-Map. Nous avons également constaté la réussite de la navigation autonome de l'AMR à l'aide de la caméra ToF et de l'algorithme RTAB-Map. Nous pensons que les résultats de nos expériences accéléreront le déploiement de la ToF pour une gamme de systèmes robotiques commerciaux.

Auteurs

Sagar Dhatrak a obtenu sa maîtrise en sciences électroniques en 2011 et a soumis sa thèse de doctorat sur le SLAM visuel monoculaire en 2021. Il travaille actuellement comme spécialiste VSLAM chez Einfochips (une société Arrow) et travaille sur la navigation autonome des robots mobiles autonomes en utilisant le SLAM visuel. Il travaille sur des systèmes embarqués et des projets liés à la robotique depuis environ six ans.

Vishal Raval est titulaire d'un diplôme d'ingénieur en électronique et communications. Il travaille actuellement en tant qu'ingénieur embarqué senior chez Einfochips (une société Arrow). Il a environ 8 ans d'expérience dans le secteur des technologies de l'information. Il est un programmeur compétent en C, C++, LINUX et ROS2. Il effectue actuellement des recherches sur la navigation des robots autonomes en utilisant le SLAM visuel avec un capteur ToF.