Une solution de vision par ordinateur fait référence à l'utilisation de caméras et d'algorithmes de vision par ordinateur pour permettre aux machines de percevoir et de comprendre leur environnement. Il s'agit d'une combinaison de la capacité de la caméra à capturer et à analyser des données visuelles et à prendre des décisions intelligentes sur la base de ces informations.

L'IA périphérique est une forme d'informatique distribuée dans laquelle tous les calculs sont effectués en dehors du nuage ou à la périphérie d'un serveur centralisé. Cette fonction de l'informatique périphérique est prise en charge par des appareils qui peuvent capturer des données visuelles et effectuer des calculs localement sur l'appareil, au plus près de la source des données, ce qui rend ces données immédiatement exploitables. Seules certaines données sont stockées dans le nuage à des fins d'analyse et de compréhension. Lors du déploiement de solutions d'intelligence artificielle en périphérie à l'aide d'un appareil photo, il est important de prendre en compte les éléments suivants :

- Résolutions et paramètres de qualité des images et des vidéos

- Exigences en matière de traitement d'images et de vidéos

- Calcul - CPU, GPU, DSP et moteur d'IA pour l'inférence et la prise de décision à la périphérie.

- Connectivité à la périphérie et vers le nuage

Le flux de la solution Edge AI comprend Capturer - Traiter - Enregistrer - Analyser - Maintenir

La phase de capture implique l'intégration, la caractérisation et le traitement des capteurs d'images. Il s'agit de la première étape pour obtenir la bonne image/vidéo, qui sera traitée par les sous-systèmes suivants. Une fois que le processus de capture fournit une bonne image/vidéo en entrée, l'étape de traitement consiste à post-traiter les blocs, à encoder/transcoder et à diffuser ces données en fonction des différents cas d'utilisation et applications. Par exemple, les exigences en matière de diffusion en continu pour les équipements de radiodiffusion sont différentes de celles des soins de santé, mais la latence est une exigence commune aux deux cas d'utilisation.

L'étape d'enregistrement permet l'enregistrement, l'archivage et la visualisation à la demande. Les différents cas d'utilisation, tels que la télématique, les drones, la robotique et les soins de santé, ont des besoins différents en matière d'enregistrement et d'archivage, y compris des aspects tels que les résolutions et la conformité aux lois en matière d'archivage.

L'étape de l'analyse est cruciale dans le contexte actuel, car l'IA est au centre de tout ce que nous faisons. C'est à ce stade que les besoins en calcul sont importants et que l'architecture devient difficile. Il est essentiel de répartir la mise en œuvre de l'IA entre la périphérie et le nuage. L'étape de maintien implique la mise en œuvre d'une orchestration qui facilite l'utilisation, le déploiement, les améliorations, l'optimisation des modèles d'IA pour des ensembles de données supplémentaires, etc.

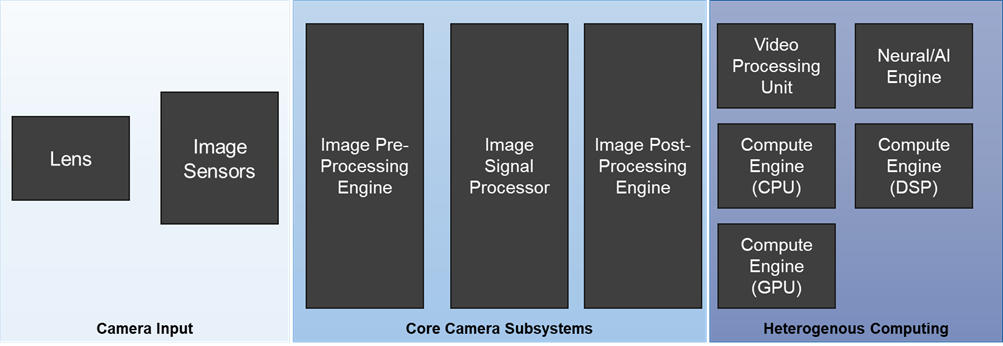

Le sous-système caméra est l'une des parties les plus critiques d'une solution de vision industrielle. Il comprend trois éléments principaux :

- Sous-système d'entrée de la caméra

- Sous-systèmes de base de la caméra

- Sous-système informatique hétérogène

Le sous-système d'entrée de la caméra se compose de l'objectif et du capteur d'image. Selon l'application finale, un ou plusieurs capteurs d'image peuvent être utilisés. Les applications robotiques utilisent différents types de capteurs d'images (RVB, temps de vol, LiDAR, etc.) pour effectuer la fusion des capteurs. Les équipements de santé destinés au diagnostic personnel peuvent comporter un ou plusieurs types de capteurs d'images pour identifier les anomalies ou effectuer des relevés. Pour les applications de sécurité et de surveillance, les capteurs d'images couramment utilisés sont RVB et IR.

Le choix de l'objectif et du capteur d'image dépend fortement du cas d'utilisation. Les applications de sécurité et de surveillance nécessitent des capteurs à densité de pixels plus élevée et à taille de pixels plus grande que les capteurs utilisés dans les téléphones cellulaires, qui n'ont pas les mêmes besoins. De même, les systèmes d'inspection nécessitent des capteurs à balayage linéaire ou à balayage de surface, qui sont plus appropriés pour ces applications.

- L'"optique" garantit que l'appareil photo capture les objets qui vous intéressent réellement.

- "Conditions d'éclairage, gamme dynamique" vise à préserver l'intensité relative entre les détails les plus clairs et les plus sombres de l'image et à fournir cette information aux algorithmes de vision dans la mesure du possible.

- "Type de cible" - Obturateur roulant pour les cas d'utilisation qui n'impliquent pas de capture de mouvement, et Obturateur global pour les cas d'utilisation qui impliquent une capture de mouvement.

- "FoV" - Cas d'utilisation tels que l'analyse du commerce de détail, où vous pouvez capturer un ensemble de données plus important (de personnes) entrant/sortant du magasin.

Le sous-système central de la caméra se compose de blocs de prétraitement, de traitement du signal d'image et de post-traitement. Ces blocs sont essentiels pour améliorer la qualité de l'image qui sera utilisée par les sous-systèmes suivants pour l'analyse et la prise de décision.

Le sous-système informatique hétérogène se concentre sur les besoins de calcul en fonction du cas d'utilisation visé. Les modèles d'IA lourds peuvent nécessiter un moteur d'IA puissant avec inférence utilisant le GPU, le DSP et le CPU. Lors de la détection de visages pour les cas d'utilisation de sécurité/surveillance, il est essentiel d'exécuter le modèle sur l'un ou l'autre de ces moteurs de calcul en fonction de la charge du système et des exigences de calcul pour une meilleure inférence. Les considérations clés pour la conception comprennent la sélection du cœur du CPU, du GPU, du DSP et des KPI associés - traitement en virgule flottante, latence de synchronisation, etc. Les moteurs d'IA sont généralement mesurés en TOPS, une méthode de mesure des performances qui fait l'objet d'une grande publicité, mais la mesure la plus importante pour les performances des moteurs d'IA est l'inférence par seconde ou la latence de l'inférence.

Grâce à sa vaste expérience et à son expertise approfondie dans la conception de solutions de caméras personnalisées, eInfochips a aidé les OEM à rester à la pointe de la technologie. En collaboration avec Arrow et Qualcomm, eInfochips a créé "Edge Labs", un centre d'excellence qui offre aux experts en la matière de Qualcomm des services de développement de produits de bout en bout, un laboratoire de pointe et des équipements pour accélérer le développement des produits. eInfochips a conçu plus de 30 modèles de caméras, en s'appuyant sur un laboratoire interne de pointe pour le réglage des images. Ils ont également de l'expérience avec les derniers cadres et outils d'IA (Tensorflow, OpenCV, Python, Caffe, Keras). De plus, eInfochips a développé une structure de caméra réutilisable (RCF) pour accélérer la mise sur le marché et réduire de manière significative les efforts de développement, en fournissant un ensemble de fonctionnalités éprouvées et testées.

Pour plus d'informations, veuillez contacter marketing@einfochips.com